連結:https://huggingface.co/papers/2311.06242

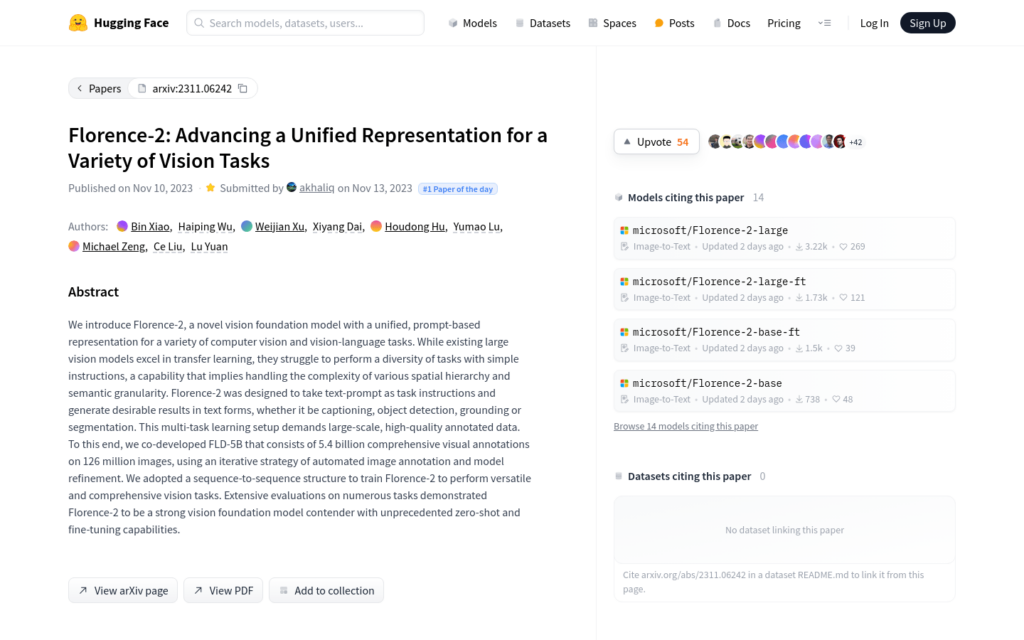

Florence-2是一個新型的視覺基礎模型,它透過統一的、基於提示的表示方式,能夠處理多種電腦視覺和視覺-語言任務。它設計為接受文本提示作為任務指令,並以文本形式生成期望的結果,無論是影象描述、目標偵測、定位還是分割。這種多工學習設定需要大規模、高質量的註釋資料。為此,我們共同開發了FLD-5B,它包含了54億個綜合視覺註釋,涵蓋1.26億張影象,使用了自動化影象註釋和模型細化的迭代策略。我們採用了序列到序列的結構來訓練Florence-2,以執行多樣化和全面的視覺任務。廣泛的評估表明,Florence-2是一個強大的視覺基礎模型競爭者,具有前所未有的零樣本和微調能力。

需求人群:

- Florence-2模型適合需要處理複雜視覺任務的研究者和開發者,特別是在影象描述、目標偵測、視覺定位和分割等領網網域。它的多工學習能力和強大的資料處理能力,使其成為推動電腦視覺和視覺-語言研究的重要工具。

使用場景示例:

- 在影象描述任務中,Florence-2能夠根據輸入的影象生成準確的描述文本。

- 在目標偵測任務中,Florence-2可以辨識影象中的多個對象,並以文本形式報告它們的位置。

- 在視覺定位任務中,Florence-2能夠將文本描述與影象中的特定區網網域關聯起來。

產品特色:

- 文本提示作為任務指令的輸入方式。

- 生成文本形式的期望結果,適用於多種視覺任務。

- 大規模、高質量的FLD-5B資料集支援。

- 自動化影象註釋和模型細化的迭代策略。

- 序列到序列結構,提高任務的多樣性和全面性。

- 零樣本和微調能力,適應不同複雜度的任務。

使用教學:

步驟1: 訪問Florence-2模型的Hugging Face頁面。

步驟2: 選擇適合您需求的模型版本,例如基礎版或大型版。

步驟3: 閱讀模型文檔,瞭解如何使用文本提示來指導模型執行任務。

步驟4: 準備您的輸入資料,可以是影象檔案或與影象相關的文本描述。

步驟5: 使用模型提供的API或接口,將輸入資料傳遞給Florence-2。

步驟6: 獲取模型輸出的結果,並根據需要進行進一步的處理或分析。

步驟7: 根據反饋調整模型引數或輸入資料,以最佳化任務效能。