Link:confident-ai

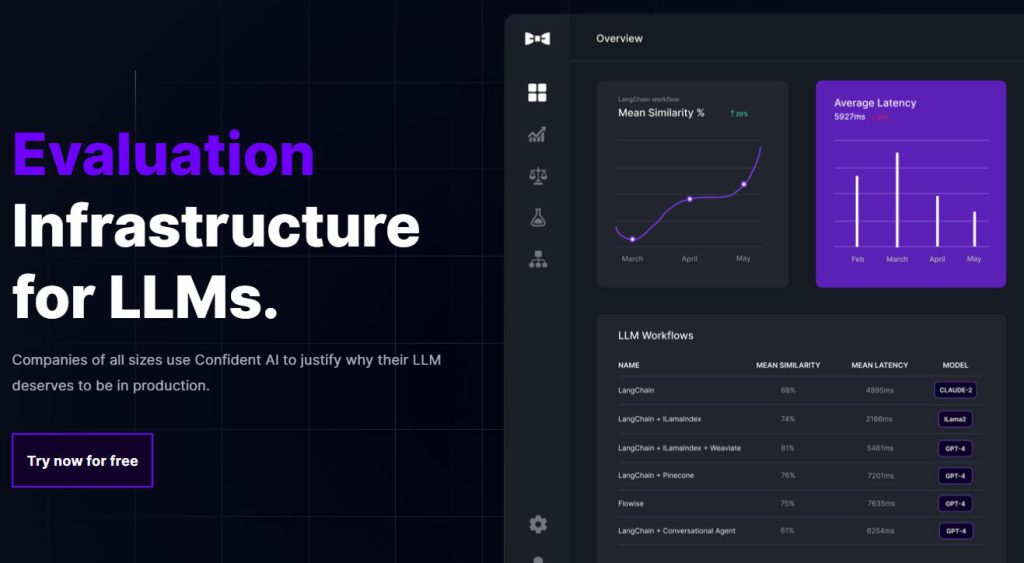

Confident AI 是一個開源的評估基礎設施,為 LLM(Language Model)提供信心。使用者可以透過編寫和執行測試用例來評估自己的 LLM 應用,並使用豐富的開源指標來衡量其效能。透過定義預期輸出並與實際輸出進行比較,使用者可以確定 LLM 的表現是否符合預期,並找出改進的方向。Confident AI 還提供了高階的差異跟蹤功能,幫助使用者最佳化 LLM 配置。此外,使用者還可以利用全面的分析功能,識別重點關注的用例,實現 LLM 的有信心地投產。Confident AI 還提供了強大的功能,幫助使用者自信地將 LLM 投入生產,包括 A/B 測試、評估、輸出分類、報告儀表盤、資料集生成和詳細監控。

需求人群:

"用於評估和最佳化 LLM 應用的效能和輸出"

使用場景示例:

為聊天機器人編寫測試用例,評估其回答的準確性

比較不同 LLM 配置的效能,選擇最佳配置

透過分析儀表盤識別 LLM 工作流中的瓶頸

產品特色:

定義預期輸出

衡量 LLM 效能

差異跟蹤

分析功能

A/B 測試

輸出分類

報告儀表盤

資料集生成

詳細監控