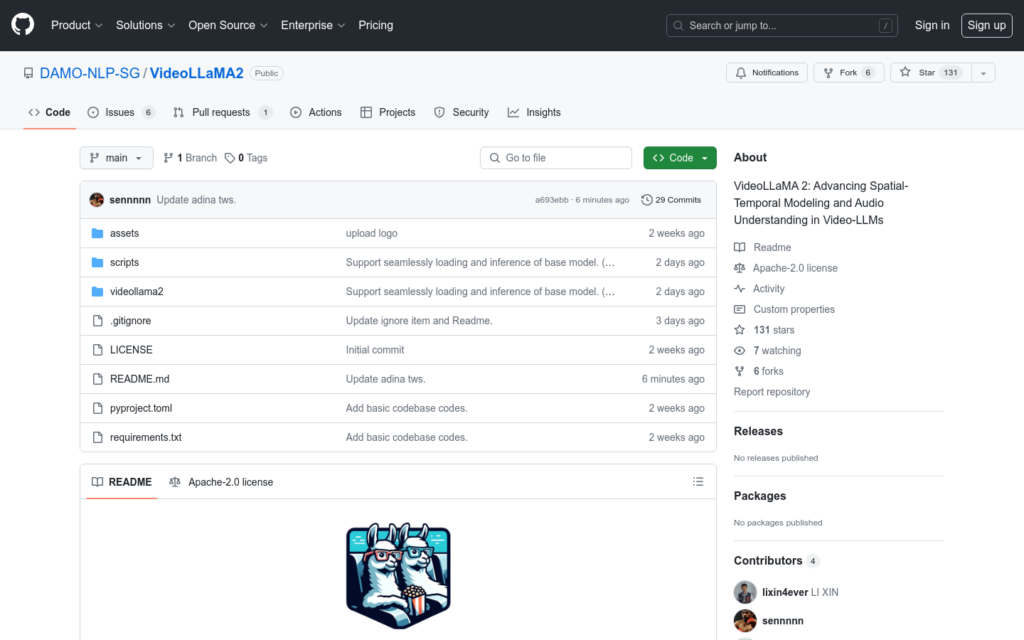

連結:https://github.com/DAMO-NLP-SG/VideoLLaMA2

VideoLLaMA 2 是一個針對影片理解任務最佳化的大規模語言模型,它透過先進的空間-時間建模和音訊理解能力,提升了對影片內容的解析和理解。該模型在多選影片問答和影片字幕生成等任務上展現了卓越的效能。

需求人群:

- VideoLLaMA 2 適用於需要高效影片內容分析和理解的研究人員和開發者,特別是在影片問答、影片字幕生成等影片理解任務中。

使用場景示例:

- 研究人員使用VideoLLaMA 2 進行影片內容的自動問答系統開發。

- 內容創作者利用該模型自動生成影片字幕,提高工作效率。

- 企業在影片監控分析中應用VideoLLaMA 2,以提升事件偵測和響應速度。

產品特色:

- 支援無縫載入和推理基礎模型。

- 提供線上演示,方便使用者快速體驗模型功能。

- 具備影片問答和影片字幕生成的能力。

- 提供訓練、評估和模型服務的程式碼。

- 支援自訂資料集的訓練和評估。

- 提供了詳細的安裝和使用指南。

使用教學:

首先,確保全裝了必要的基礎依賴,如Python、Pytorch和CUDA。

透過GitHub頁面獲取VideoLLaMA 2的程式碼庫,並按照指南安裝所需的Python包。

準備模型所需的checkpoints,並按照文檔說明啟動模型服務。

使用提供的腳本和命令列工具進行模型的訓練、評估或推理。

根據需要調整模型引數,最佳化模型效能。

執行線上演示或本地模型服務,體驗模型的影片理解和生成能力。