連結:https://github.com/deepseek-ai/DeepSeek-Coder-V2

DeepSeek-Coder-V2是一個開源的Mixture-of-Experts (MoE) 程式碼語言模型,效能與GPT4-Turbo相當,在程式碼特定任務上表現卓越。它在DeepSeek-Coder-V2-Base的基礎上,透過6萬億token的高質量多源語料庫進一步預訓練,顯著增強了編碼和數學推理能力,同時保持了在通用語言任務上的效能。支援的程式語言從86種擴充到338種,上下文長度從16K擴充到128K。

需求人群:

- DeepSeek-Coder-V2主要面向開發者、程式設計教育者和程式碼智慧工具開發者。它透過提供高質量的程式碼生成、補全和修正功能,幫助提升程式設計效率和教育質量,同時為程式碼智慧工具提供強大的後端支援。

使用場景示例:

- 開發者使用DeepSeek-Coder-V2生成特定功能的程式碼。

- 程式設計教育平臺整合該模型,提供自動化的程式設計作業評估。

- 程式碼智慧工具利用DeepSeek-Coder-V2進行程式碼補全和錯誤偵測。

產品特色:

- 支援多種程式語言,從86種擴充到338種。

- 上下文長度支援從16K擴充到128K。

- 在標準基準測試中,與閉源模型相比,表現出色。

- 提供不同引數規模的模型下載,包括16B和236B引數版本。

- 提供與OpenAI相容的API平臺,支援免費token和按需付費。

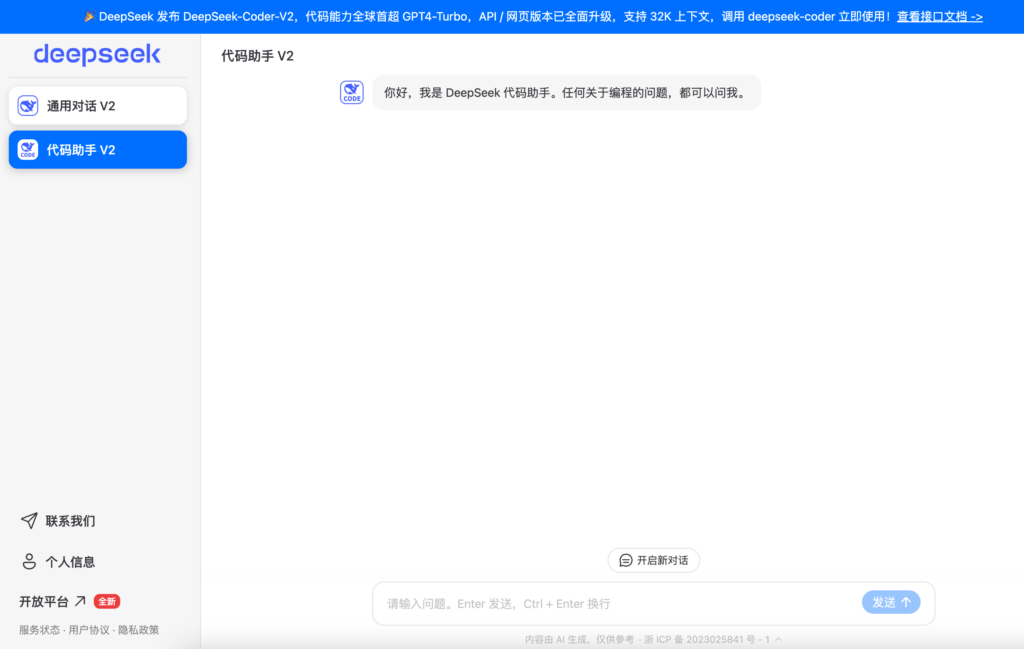

- 可在DeepSeek官網進行聊天互動體驗。

- 支援本地執行,提供詳細的使用示例和指南。

使用教學:

訪問DeepSeek-Coder-V2的GitHub頁面,瞭解模型的基本資訊和特性。

根據需要選擇合適的模型版本進行下載,例如DeepSeek-Coder-V2-Lite-Base或DeepSeek-Coder-V2-Instruct。

閱讀和遵循本地執行指南,設定環境並載入模型。

使用Huggingface的Transformers庫或vLLM進行模型推理,執行程式碼生成、補全或其他程式設計輔助任務。

訪問DeepSeek官網,體驗聊天互動功能,直接與模型進行對話。

註冊並使用DeepSeek平臺的API服務,整合到自己的應用程式中。