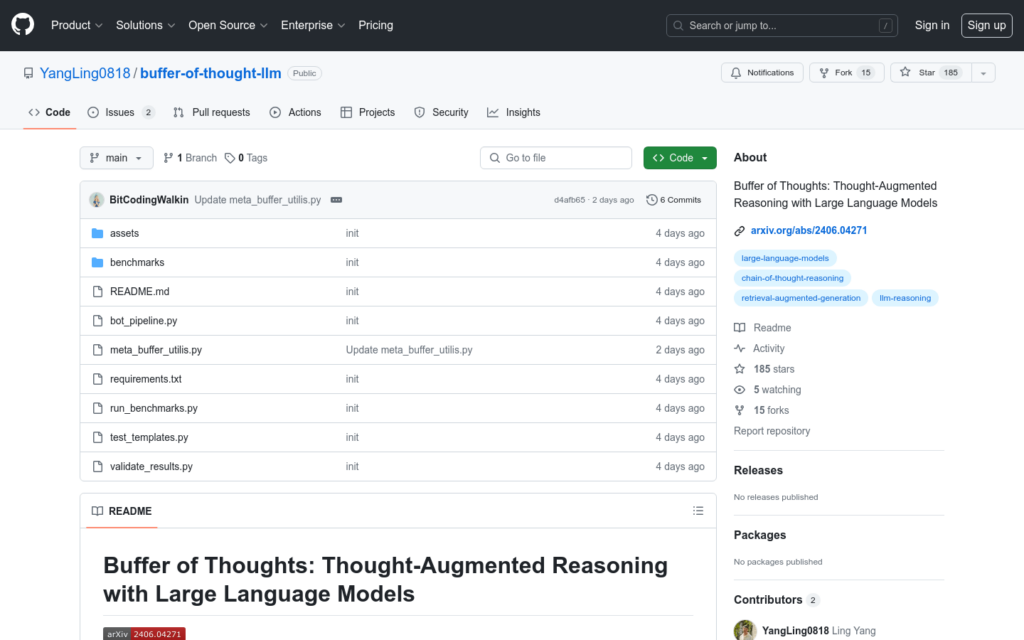

連結:https://github.com/yangling0818/buffer-of-thought-llm

Buffer of Thoughts (BoT) 是一種新型的思考增強推理方法,旨在提高大型語言模型(LLMs)的準確性、效率和魯棒性。透過引入一個元緩衝區來儲存從各種任務的問題解決過程中提取的高階思考範本,稱為思考範本。對於每個問題,檢索一個相關的思考範本,並適應性地將其實例化為特定的推理結構以進行高效推理。此外,還提出了一個緩衝區管理器來動態更新元緩衝區,從而隨著解決更多工而增強其容量。

需求人群:

- 目標受眾主要是需要利用大型語言模型進行復雜問題解決的研究者和開發者。BoT透過提供思考範本和動態緩衝區管理,使得這些使用者能夠更高效、更準確地利用LLMs進行推理任務,特別適合於需要處理大量資料和複雜邏輯的領網網域。

使用場景示例:

- 在’24點遊戲’中透過BoT提升解題準確率

- 利用BoT在’Checkmate-in-One’任務中快速找到解決方案

- 透過BoT進行’Word Sorting’任務以最佳化單詞排序邏輯

產品特色:

- 透過元緩衝區儲存和檢索問題解決過程中的思考範本

- 適應性地實例化思考範本以進行高效推理

- 動態更新元緩衝區以增強問題解決能力

- 在多個推理密集型任務上實作顯著的效能提升

- 與GPT-4、Llama3-70B等不同LLMs相容

- 提供了易於使用的命令列接口進行快速測試和驗證

使用教學:

首先,克隆或下載Buffer of Thoughts的程式碼庫到本地

設定環境,進入專案目錄並建立Python虛擬環境,安裝依賴

選擇一個任務,例如’gameof24’,並準備相應的API金鑰和模型ID

透過命令列接口執行BoT,輸入必要的引數,如任務名、API金鑰和模型ID

在/benchmarks目錄下檢視任務資料

實驗結果將儲存在/test_results目錄中

使用validate_results.py腳本來驗證測試結果並列印出準確率