連結:https://make-an-audio-2.github.io

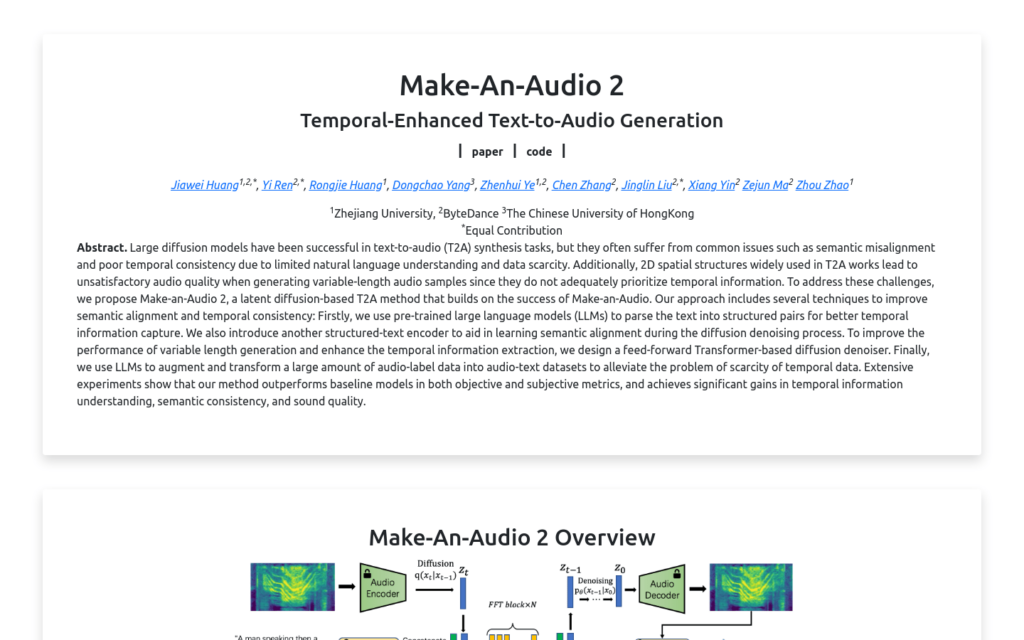

Make-An-Audio 2是一種基於擴散模型的文本到音訊生成技術,由浙江大學、字節跳動和香港中文大學的研究人員共同開發。該技術透過使用預訓練的大型語言模型(LLMs)解析文本,最佳化了語義對齊和時間一致性,提高了生成音訊的質量。它還設計了基於前饋Transformer的擴散去噪器,以改善變長音訊生成的效能,並增強時間資訊的提取。此外,透過使用LLMs將大量音訊標籤資料轉換為音訊文本資料集,解決了時間資料稀缺的問題。

需求人群:

- 該技術的目標受眾是音訊合成領網網域的研究人員和開發者,以及需要高質量文本到音訊轉換的應用場景,如自動配音、有聲讀物製作等。Make-An-Audio 2透過其先進的技術,能夠生成與文本內容語義對齊且時間一致的高質量音訊,滿足這些使用者的需求。

使用場景示例:

- 自動生成有聲讀物的背景音效和對話

- 為影片內容自動新增旁白和音效

- 建立虛擬角色的聲音,用於遊戲或動畫

產品特色:

- 使用預訓練的大型語言模型(LLMs)解析文本,最佳化時間資訊捕獲

- 引入結構化文本編碼器,輔助學習擴散去噪過程中的語義對齊

- 設計基於前饋Transformer的擴散去噪器,改善變長音訊生成效能

- 利用LLMs增強和轉換音訊標籤資料,緩解時間資料稀缺問題

- 在客觀和主觀指標上超越基線模型,顯著提升時間資訊理解、語義一致性和聲音質量

使用教學:

步驟1: 準備自然語言文本作為輸入

步驟2: 使用Make-An-Audio 2的Text Encoder解析文本

步驟3: 結構化文本編碼器輔助學習語義對齊

步驟4: 利用擴散去噪器生成音訊

步驟5: 調整生成音訊的長度和時間控制

步驟6: 根據需要修改結構化輸入以精確控制時間

步驟7: 生成最終的音訊輸出