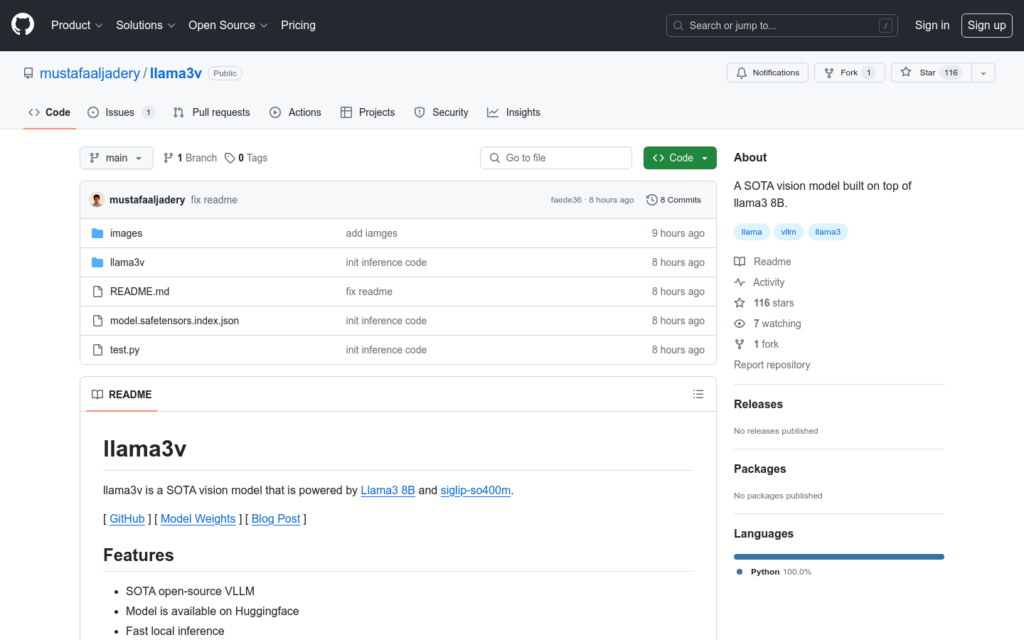

連結:https://github.com/mustafaaljadery/llama3v

llama3v是一個基於Llama3 8B和siglip-so400m的SOTA(State of the Art,即最先進技術)視覺模型。它是一個開源的VLLM(視覺語言多模態學習模型),在Huggingface上提供模型權重,支援快速本地推理,併發布了推理程式碼。該模型結合了影象辨識和文本生成,透過新增投影層將影象特徵對映到LLaMA嵌入空間,以提高模型對影象的理解能力。

需求人群:

- 目標受眾為需要進行影象辨識和文本生成的研究人員和開發者。他們可以利用llama3v模型進行影象特徵提取和文本生成,從而在影象理解和多模態資料處理方面取得更好的效果。

使用場景示例:

- 研究人員使用llama3v進行影象和文本的聯合分析研究

- 開發者利用模型進行影象辨識和自動標註

- 企業使用該模型進行產品影象的智慧分類和檢索

產品特色:

- 使用Huggingface提供的模型權重進行快速本地推理

- 結合siglip-so400m模型進行視覺辨識

- Llama3 8B模型用於多模態影象-文本輸入和文本生成

- 在預訓練過程中凍結除投影層外的所有權重

- 在微調過程中更新Llama3 8B模型權重,同時凍結siglip-so400m模型和投影層

- 生成合成多模態資料以增強多模態文本生成能力